En la era digital actual, la información es un recurso invaluable que se genera y se almacena en diversas plataformas de la web. Entre las diversas maneras de recolectar esta información, destaca una técnica conocida como scraping web. Este proceso permite a los usuarios extraer datos valiosos de sitios web de forma automatizada, facilitando una serie de aplicaciones que van desde la investigación de mercado hasta la monitorización de precios. Entender qué es el scraping y cómo puede utilizarse eficazmente es esencial para cualquier persona que busque aprovechar el vasto océano de datos desbordante en internet.

En este artículo, exploraremos a fondo qué implica el scraping web, sus métodos, herramientas más comunes, así como las implicaciones éticas y legales de su uso. Analizaremos también las múltiples aplicaciones que esta técnica tiene en el mundo contemporáneo, subrayando su relevancia en sectores como el marketing, la competitividad empresarial y la ciencia de datos. Al final de esta lectura, tendrás una visión clara de cómo el scraping web puede transformar la manera en que gestionas y operas con datos en tu entorno profesional.

¿Qué es el scraping web?

El scraping web es una técnica utilizada para extraer información de sitios web. Se refiere al proceso de recuperar contenido de la web de manera automatizada, utilizando software que simula la navegación humana. A través de esta técnica, los datos se convierten en un formato estructurado, facilitando su análisis y uso posterior. Este proceso puede involucrar la recopilación de texto, imágenes, video, y cualquier otro tipo de información que esté disponible públicamente en internet.

Mira TambiénQué son los formularios de suscripción y cómo hacerlosEl scraping ha evolucionado significativamente desde sus inicios. En la actualidad, existen diversas herramientas y lenguajes de programación (como Python, JavaScript, entre otros) que facilitan esta tarea. Los desarrolladores pueden construir scrapers personalizados, capaces de adaptarse a diferentes formatos de datos y estructuras de sitios web. Sin embargo, esta capacidad para acceder a grandes volúmenes de información plantea preguntas importantes sobre el respeto a la propiedad intelectual y los términos de servicio de los sitios web que se están raspando.

Métodos de scraping web

Existen varios métodos de scraping web, cada uno con sus ventajas y desventajas. Los más comunes incluyen el web scraping basado en código, el uso de herramientas de scraping visual y el scraping mediante APIs.

El web scraping basado en código es el método más técnico y flexible. Implica la escritura de scripts en lenguajes de programación como Python, utilizando bibliotecas como Beautiful Soup o Scrapy. Esta opción permite un alto grado de personalización y es ideal para usuarios avanzados que desean extraer datos de manera precisa y eficiente. Sin embargo, requiere conocimientos técnicos que pueden no estar al alcance de todos.

Las herramientas de scraping visual, por otro lado, permiten a los usuarios no técnicos extraer datos a través de una interfaz gráfica. Herramientas como ParseHub o Octoparse permiten a los usuarios seleccionar los elementos que desean raspar directamente en una página web sin necesidad de escribir código. Estas herramientas son generalmente más fáciles de usar, pero pueden ser limitadas en cuanto a la personalización y la complejidad de las tareas que pueden realizar.

Mira TambiénRelaciones con influencers: cómo hacerlo desde tu sitio webFinalmente, el scraping mediante APIs es una forma legítima y preferida de extraer datos. Muchas empresas ofrecen interfaces de programación de aplicaciones (API) que permiten a los desarrolladores acceder a sus datos de manera directa y segura. Este método es a menudo más confiable y respetado, ya que las APIs están diseñadas para este propósito y reducen el riesgo de ir en contra de los términos de servicio de un sitio web.

Herramientas populares para el scraping web

El uso de herramientas de scraping web ha proliferado en los últimos años debido a la creciente demanda de información. A continuación, se presentan algunas de las herramientas más populares que los profesionales y desarrolladores utilizan hoy en día.

Python es uno de los lenguajes más populares para el scraping web, gracias a su simplicidad y la fuerza de sus bibliotecas especializadas. Beautiful Soup y Scrapy son dos de las bibliotecas más utilizadas. Beautiful Soup permite la extracción de datos de documentos HTML y XML de forma simple, mientras que Scrapy es un marco más completo que permite desarrollar scrapers a gran escala de forma eficiente.

Por otro lado, herramientas como Octoparse y ParseHub ofrecen soluciones sin código que pueden ser ideales para aquellos que no tienen habilidades de programación. Estas aplicaciones proporcionan una interfaz de arrastrar y soltar, lo que facilita mucho el proceso para los principiantes. Este tipo de herramientas es especialmente útil cuando se trabaja con múltiples sitios web, ya que pueden adaptarse a diferentes estructuras de datos.

Mira TambiénCómo fomentar el contenido generado por usuariosOtras herramientas notables incluyen Apify, que permite el scraping y la automatización web, y Import.io, que ofrece potentes capacidades de extracción de datos en la nube. Además, algunas extensiones de navegador, como Web Scraper y Data Miner, ofrecen funcionalidades rápidas para la recolección de datos de páginas específicas sin necesidad de configuraciones complejas.

Aplicaciones del scraping web en la actualidad

Las aplicaciones del scraping web son vastas y continúan creciendo a medida que más empresas comprenden el valor de los datos. Una de las aplicaciones más notables se encuentra en el ámbito del marketing y análisis de competencia. Las empresas pueden utilizar el scraping para rastrear los precios de productos de sus competidores, identificar nuevas tendencias en el mercado, y analizar reseñas de productos. Este tipo de análisis puede ofrecer insights críticos sobre cómo posicionar sus propios productos y estrategias de precios.

En el sector de la investigación, el scraping web se emplea frecuentemente para recopilar datos que alimentan estudios y análisis. Investigadores académicos o analistas de datos pueden utilizar esta técnica para obtener datos sobre temas específicos que están totalmente disponibles en línea. De esta manera, se reducen costos y se optimiza el tiempo, ya que los datos pueden ser recolectados automáticamente en lugar de hacerse de forma manual.

Otra aplicación notable es en el ámbito de las finanzas y análisis de mercado. Los inversores y analistas utilizan el scraping para obtener información sobre acciones, índices, y otros activos que son relevantes para sus decisiones de inversión. Esto les permite estar un paso adelante de la competencia, utilizando datos actualizados en tiempo real que pueden influir en sus estrategias de inversión.

Implicaciones éticas y legales del scraping web

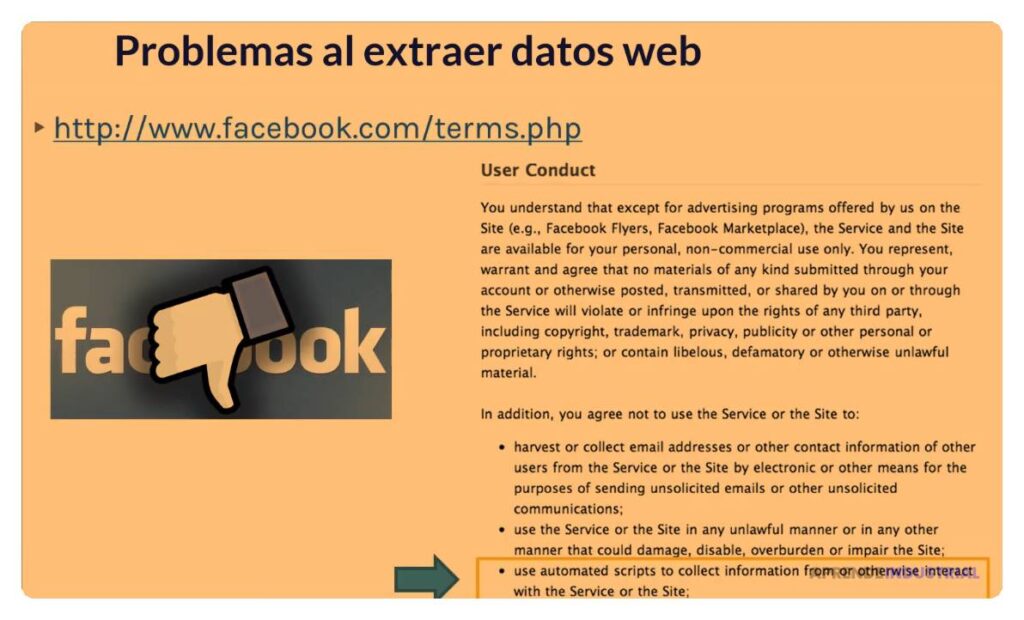

Con la facilidad para extraer datos de la web, surgen cuestiones éticas y legales que los usuarios de scraping web deben considerar. Uno de los aspectos más debatidos es el cumplimiento de los términos de servicio de los sitios web. Muchos sitios prohíben explícitamente el scraping en sus condiciones, y su incumplimiento puede resultar en bloqueos o acciones legales.

Además, la recopilación de datos personales puede infringir políticas de privacidad y regulaciones, como el Reglamento General de Protección de Datos (GDPR) en Europa. Las empresas que deciden obtener datos de manera ética y responsable, asegurándose de cumplir con todas las regulaciones pertinentes, no solo evitarán problemas legales, sino que también fomentarán una buena reputación entre sus usuarios e inversores.

El respeto por los derechos de propiedad intelectual también debe ser considerado. Algunos datos en la web están protegidos por derechos de autor, y el uso indebido de esta información podría llevar a litigios. Por lo tanto, es esencial que quienes utilizan el scraping comprendan y respeten los derechos de los creadores y las plataformas que albergan estos datos.

Conclusión: El futuro del scraping web

El scraping web se ha convertido en una herramienta fundamental en la era de la información. Su capacidad para extraer datos de manera rápida y eficiente lo convierte en un recurso valioso en una amplia variedad de sectores. Sin embargo, con esta capacidad también se presentan importantes responsabilidades respecto al cumplimiento de la ética y las leyes. A medida que la tecnología avanza, es probable que el scraping web siga evolucionando, abriendo nuevas oportunidades para la recolección de datos, pero siempre en el marco del respeto y la responsabilidad.

Entender el scraping web y sus aplicaciones es esencial para aquellos que buscan extraer y utilizar datos en beneficio propio o de su organización. La clave radica en hacerlo de manera ética y legal, asegurándose de que el acceso a la información no infrinja derechos ni comprometa la privacidad de los individuos. Con el correcto enfoque, el scraping web puede ser una herramienta poderosa para la innovación y el crecimiento en un mundo impulsado por datos.